Python初心者向けの実践的なチュートリアルまとめ!5つの学習手順も解説

あのマイクロソフトが導入するほどの高品質なPythonスクール。AI・機械学習・Python特化型。給付金で最大70%OFF。

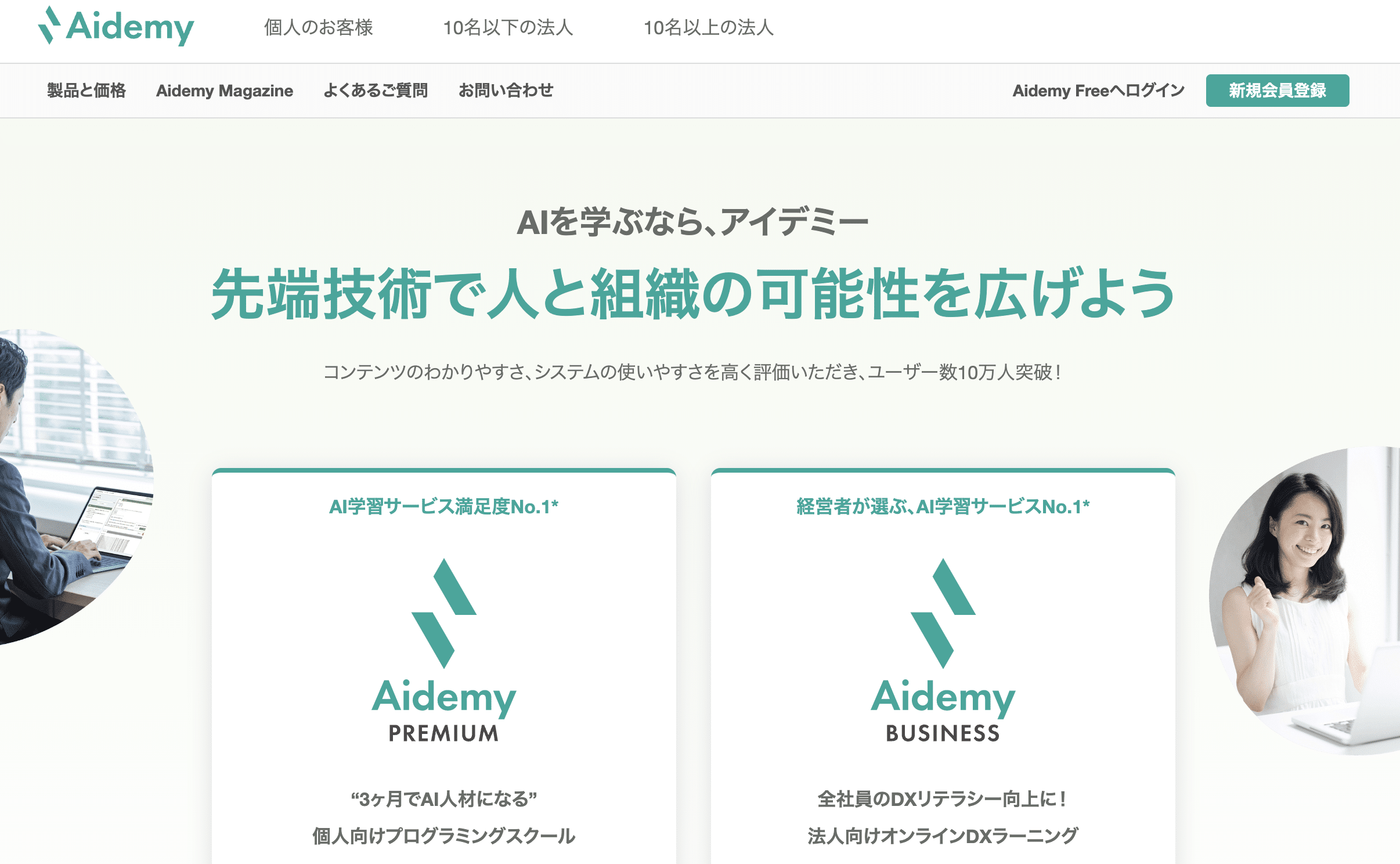

【第2位】Aidemy(公式:https://aidemy.net/)

日本の大企業のDXで利用されている、高品質なPythonスクール。こちらもPython・AI・機械学習特化型

【第3位】TechAcademy(公式:https://techacademy.jp/)

価格を抑えて、教養としてAI・Pythonを学びたいなら!オリジナルアプリ開発までサポート。知名度抜群の総合型プログラミングスクール。

【第4位】CodeCamp(公式:https://codecamp.jp/)

価格を抑えながらマンツーマンで教養としてPython・データ収集を学びたいなら!同じく知名度抜群の総合型プログラミングスクール。

「プログラミング初心者だけど、これからPythonを学んで、自動化アプリやデータ分析アプリを作ってみたい!でもどうやって勉強すればいいの・・・?」

プログラミングはただ闇雲に進めても一向に自分の作りたいものが作れるようになりません。

理由としては以下のことがあるからなんですね。

- 基礎学習に時間をかけてもそこまで成長しない

- 作りたいものから必要なものだけをこなしていくことが重要

- 学習→エラーやわからないこと→解決→学習・・というループを繰り返すことが大切

目次 (PRも含まれます)

- 1 STEP1 まだPythonに触れたことがない人 → まずはPythonの基礎を学ぼう

- 2 STEP2 データの自動収集がしたかったら、PythonでWebスクレイピングを学ぼう

- 3 STEP3 データ分析を学ぼう

- 4 STEP4 Webアプリを作ろう

- 5 STEP5 Web APIアプリを作ろう

- 6 Pythonの初心者なら知っておきたい失敗3パターン

- 7 Python初心者にありがちな失敗パターンを避けるには?

- 8 よくある質問①:Pythonって何ができるの?

- 9 よくある質問②:Pythonを学ぶなら、書籍のほうがよい?インターネットで学ぶほうがよい?

- 10 よくある質問③:Pythonを学ぶなら、無料の教材でよい?

- 11 最後に

STEP1 まだPythonに触れたことがない人 → まずはPythonの基礎を学ぼう

まずはPythonの基礎を学びましょう。なんの応用をやるにしても、基礎を学習する必要があります。

実際にコードを書くときに、

- 文字列等の基本的な型の知識

- if文

- for文

- while文

- 関数文

- クラス

などはしっかりと理解しておく必要があります。

Pythonの基礎を学べるサイト

Python の基礎を学ぶにはProgateが一番おすすめです。

Progateがおすすめな理由は

- オンライン上で環境構築を一切する必要がなく、ブラウザで学べる → どのPCでもインターネットさえ開けば学べる

- エラーが初心者用にわかりやすくなっているので、Progateで学べば自己解決する力がつきやすい

からです。個人的には書籍などで学ぶよりも、実際にコードを書いて学んだ方が効率的だと思います。まずはプロゲートを使って Python の基礎を学びましょう。

無料のコースだけでも十分学ぶことができます。Progateの

- PythonⅠ

- PythonⅡ

- PythonⅢ

あたりはマスターできるようにしておきましょう。ここがすべての基礎となります。

Webアプリ、スクレイピングを学びたかったら、HTML、CSSを学ぼう

Pythonの基礎が身につき、今後後述するWebアプリ、スクレイピングを学びたかったらHTMLとCSSを学びましょう。

HTMLとは

HTMLとは、Webページの文章や、リンクなどを設定する言語となります。たとえば、僕がこのページに「Googleへアクセス」というリンクを張る場合、HTMLで書くとこのようになります。

<a href="www.google.com">Googleへアクセス</a>ほかにもただの文章を書く場合は、このようになります。

<p>たたの文章を書く場合は、このようにpタグで書こうとHTML上で書くことができます</p>

つまり、HTMLとは簡単にいうと、Webページの内容を直接記入する言語なのです。

CSSとは

CSSは、HTMLを装飾する言語です。例えば、さきほどHTMLで以下のような文を作成しました。

<p>たたの文章を書く場合は、このようにpタグで書こうとHTML上で書くことができます</p>

また、背景色を黒にしたい場合は、CSSで書くとこのようになります。

p {color:red; background-color:black}

このように、CSSはHTMLを修飾する言語になるわけですね。

Web上の文書を記述するプログラミング言語なのですが、これがわかると後述するスクレイピングという技術を利用する際に、理解しやすくなります。

STEP2 データの自動収集がしたかったら、PythonでWebスクレイピングを学ぼう

Python の基礎を学んだら次は Web スクレイピングを学んでみましょう。

Webスクレイピングとは?

Web スクレイピングは、Web上からデータを取得する技術のことです。

例えばこんなことができるようになります。

- EC サイトの在庫データやチケット情報の確認などを全て自動化して確認

- 営業名簿を作るために、Web上のデータから5分で1万件のデータを自動収集し、CSVにエクスポート

- 商品の売り切れを自動でbotがクロールして、売切れたらメールで通知

かなり便利ですよね。

Webスクレイピングをできるようになるためには、どのような知識が必要?

Webスクレイピングを身に着けるには

- Pythonの基礎知識 ※学習済み

- HTML、CSSの基礎知識 ※学習済み

- Pythonの環境構築能力

- PythonでHTTP通信ができるRequestsの利用方法

- Pythonで取得したHTMLデータを整形できるBeautifulSoupの利用方法

- PythonでBeautifulSoupで整形したデータをCSVにエクスポートできるPandasの利用方法

Pythonの環境構築とは?

Progateでは、オンライン上のエディタを利用すれば、Pythonが実行できるのですが、そうではない場合は自身でPythonが動作する環境を作る必要があります。

環境構築をする方法は大きく分けて二つあって

- 自身のパソコンにPythonを実行できる環境を構築する

- Pythonが実行できるWeb上のサービスを利用して、Pythonを動作させる

という方法があります。ゼロからPythonの環境構築をするのは、少し難しいかもしれません。ですので、初心者であれば、後者の方法を使うのがよいと思います。

Web上でPythonの実行環境が整えられるサービスとしてはGoogle Colaboratoryをおすすめします。以下の画像のような感じで、簡単にWebからPythonを実行できるようになります。

PythonでHTTP通信ができるRequestsとは?

Requestsは、オンライン上で、 Web サイトと通信して情報を取得したり送信したりすることができるようになるライブラリです。例えば、あるURLから記事のデータを取得するようなコードはこんなシンプルなコードになります。

〇BeautifulSoupとは

BeautifulSoupとは、ネット上から取得した Web ページの文章 html を整形し自分が欲しいような情報の形で取得することができるライブラリです。

よく使われるパターンとしては、RequestsでWeb上のデータを取得した際に、そのデータをBeautifulSoupで整形する感じですね。

〇Pandasとは

Pandasは、取得したデータを行列で扱うことができるライブラリです。Pandasを使えば、 逆に取得した CSV を読み込んでデータを加工することができます。Requestsでデータをとってきて、BeautifulSoupでデータを整形、最後にPandasでデータを処理してCSVにエクスポートすることができます。

〇スクレイピングを学ぶのにお勧めのチュートリアル

繰り返しますが、Webスクレイピングをするためには、

- Pythonの基礎知識 ※学習済み

- HTML、CSSの基礎知識 ※学習済み

- Pythonの環境構築能力

- PythonでHTTP通信ができるRequestsの利用方法

- Pythonで取得したHTMLデータを整形できるBeautifulSoupの利用方法

- PythonでBeautifulSoupで整形したデータをCSVにエクスポートできるPandasの利用方法

の知識が必要です。しかし、ほとんどのチュートリアルはこれらの知識を別々に学ぶことになるので、初学者にはなかなかイメージしづらいと思います。

①Pythonによるスクレイピング①ブログ記事を自動収集してみよう

Requests、BeautifulSoup、Pandasを学ぶ場合、僕が作ったManajobの『Pythonコース』がかなりおすすめです。相当実践的な内容になっていて、

- 実際に僕のブログからスクレイピング

- さらに、取得したデータの記事名、URLをCSV

を、実際に少しずつコードを書きながら学んでいきます。こちらは『Pythonコース』の一部となっていますが、こんな感じで動画+テキストで、コードを一つ一つ細かく紹介して学習できるようになっているので、おすすめです。中身はこんな感じですね!

②スクレイピング自動ログインを行い、データを収集しよう

また、上級編として、ログインが必要なWebサイトからデータを収集するチュートリアルもあります。

- ログインが必要なWebサイトからSeleniumを利用してスクレイピングする

といった処理を、簡単なコードで実装できるようになります。

STEP3 データ分析を学ぼう

次に Python を利用してデータ分析を学ぶ方法です。データを取り扱う上での必要なライブラリは、Pandas, Matplotlibです。

Pandasとは

Pandasは、データの加工に加えて、簡単な統計も扱うことができます。例えば、各変数間の相関係数を取得したり、データの要約を行うことができます。

Matplotlibとは

Matplotlibは、 Python 上でデータをグラフに描画するツールです。例えば折れ線グラフやヒストグラム円グラフ棒グラフなどをプログラミングで作成することができます。

データ分析でお勧めのチュートリアル

① 【ソーシャルメディアのデータ分析①】Pythonでツイッターのオリジナルデータから、拡散されやすいツイートを分析してみよう!

Twitter上のツイートのデータを分析して、どういうツイートがリツイートされやすいのかを分析したチュートリアル「Pythonでツイッターのオリジナルデータから、拡散されやすいツイートを分析してみよう!」を作りました。このチュートリアルで学べるのは

- Pandasを利用して、ツイートのデータの前処理を行う

- ツイートのデータをもとに、PandasやMatplotlibを利用して、拡散されやすいツイートのデータを相関係数等を用いながら分析する

ということをやっています。

- 実際の生のデータを利用して分析してみたい

- 実際にデータを分析する流れを抑えておきたい

という方には、ぜひ読んでいただきたいチュートリアルです。

STEP4 Webアプリを作ろう

さて、次にPythonでWebアプリを作るために必要な基礎知識を身につけましょう。

Python で WEB アプリケーションを学びたい人は、以下の項目を学習しましょう。

- HTMLとCSS

- JavaScript

- jQuery

- Bootstrapを学びましょう。

- Pythonのマイクロフレームワークである、Flask

Flaskとは

Flaskは、 Python 上で Web アプリケーションを作ることができるマイクロフレームワークです。あるページにアクセスした時に、ある特定のページを見せることができるような処理を行うことができます。

PythonでWebアプリを作る際のお勧めのチュートリアル

①Python Webアプリ開発:Flaskを利用して、Twitterの分析Webアプリを作ろう

Manajobの『Pythonコース』のWebアプリ開発チュートリアルでは、以下のことを学びます。

- Twitter APIに連携して、アカウントのいいね数とフォロワー数を取得

- それをWebアプリとしてグラフで分析できるサイトの作成

完成したもののイメージは、こんな感じになります。

Twitter のデータを取得してそのデータをもとにより評価されたツイートを分析することができるアプリケーションです。このチュートリアルに従って実際にアプリを作ってみると学びが深いと思います。

STEP5 Web APIアプリを作ろう

Web APIとは、簡単に言うと、外部サービスの情報窓口です。

- Twitterから自分のツイートをダウンロードしたい!

- Instagramから、有名人の画像を一括ダウンロードしたい!

という場合に、Webブラウザ経由ではなく、HTTPという通信経由で、ツイッター内のデータにアクセスすることができます。

Web APIが使えると、何が嬉しいのかを簡単にまとめます。

- 自作のサービス上で、外部アプリケーションのデータを利用した、混ぜ合わせたアプリ(マッシュアップアプリ)を作れる

- 普通にブラウザでデータを収集すると、手動で「次へ」ボタンをクリックして全記事を確認しなければならないが、APIを利用すると、一瞬で可能

- Pythonで自動化プログラムを組めば、データの自動収集をブラウザではなくプログラムから実行できるので、ブラウザ操作しなくても放置するだけでデータの取得が可能

ということで、外部のアプリの機能を自分のアプリに取り入れたりすることができるわけですね。

Pythonを利用したWeb APIのチュートリアル

PythonでWeb APIを学ぶためのチュートリアルは、Manajobの『Pythonコース』「PythonによるWeb API②顔認識APIを利用して、似ている人を推定しよう」がおすすめです。

このチュートリアルでは

- AKB48の120人分の画像を

- Bing Search APIを利用して、5000枚自動取得し

- 最終的にCSV形式に保存する

といったことが学べるチュートリアルとなります。

はじめてWeb APIを利用してみたいという方には非常におすすめできます。

Pythonの初心者なら知っておきたい失敗3パターン

学習→わからない・エラー→解決→学習→…というサイクルを高速で回すことが効率的に学習を進めていくコツですが、初心者の場合、どうしてもプログラミング学習のコツやエラーの解決法が身についてないので、ここで詰まってしまいがちです。

主な失敗パターンを挙げるとするなら以下の3パターンです。

- Progateで基礎ばかり学習する

- 基礎からチュートリアルに進む時にわからないことやエラーが多すぎて詰まる

- データ分析や機械学習をしたい場合は、専門性が高く、学ぶことも多い

Progateで基礎ばかり学習する

基礎からチュートリアルに進む時にわからないことやエラーが多すぎて詰まる

データ分析や機械学習をしたい場合は、専門性が高く、学ぶことも多い

プロゲートで基礎を固めて、チュートリアルサイトを活用して学習を進めていけば、なるべく費用を抑えて学習していくことができますが、これは、すでにエンジニアとしてなんらかの言語を習得しており、プログラミングの型がわかっているからできることなんですね。

Python初心者にありがちな失敗パターンを避けるには?

先ほど説明した失敗パターンを避けるには、「メンターをつけてプロからフィードバックをもらう」ことが重要です。

特に、エンジニアとして何らかの言語を習得していない場合やなるべくわからないことやエラーに割く時間を減らして効率的に学習を進めていくには、メンターをつけるようにしましょう。

- 周りにPythonに明るいエンジニアの方がいるのであればメンターになってもらいましょう。

- もしいないのであればプログラミングスクールへ通うのもおすすめです。

もし周りにいないのであれば、メンターを探す必要があります。一番手っ取り早いのは、プログラミングスクールへ通うことです。

プログラミングスクールでは、以下のメリットがあります。

- モダンな技術がわかり、効率的に学習できる学習ロードマップ

- 現役のエンジニアからフィードバックがもらえたりすぐに質問できる環境

- メンターや業界に詳しいカウンセラーと業界やキャリアについて相談ができる

なので、以下の方にはおすすめです。

- 最短で成果物を作れるようになりたい方

- 挫折しにくい環境で、自分の学習の方向性など気にせず、学習に専念したい方

学習をある程度進めてからでもいいのですが、「自分の作りたいアプリのゴールには何が必要なのか?」確認する上でも、なるべく早めに無料カウンセリング等を利用して学習の方向性は決めておくのが重要です。

特にキカガクでは、無料登録で機械学習とPythonが学べる20時間分の講座と無料カウンセリングが受けられるので、一度体験してみるのがおすすめです。

あのマイクロソフトが導入するほどの高品質なPythonスクール。AI・機械学習・Python特化型。給付金で最大70%OFF。

【第2位】Aidemy(公式:https://aidemy.net/)

日本の大企業のDXで利用されている、高品質なPythonスクール。こちらもPython・AI・機械学習特化型

【第3位】TechAcademy(公式:https://techacademy.jp/)

価格を抑えて、教養としてAI・Pythonを学びたいなら!オリジナルアプリ開発までサポート。知名度抜群の総合型プログラミングスクール。

【第4位】CodeCamp(公式:https://codecamp.jp/)

価格を抑えながらマンツーマンで教養としてPython・データ収集を学びたいなら!同じく知名度抜群の総合型プログラミングスクール。

キカガク:最大70%割引き!給付金を使ってお得に学べる高品質Python特化型スクール

キカガク公式:

https://www.kikagaku.ai/

キカガクは、給付金をもらってお得に学習しながらAI人材を目指すことができる、完全オンラインのプログラミングスクールです。

コースの特徴

オンライン動画学習サービス、Udemyでも絶賛された高品質の学習コンテンツ

引用:キカガク公式

キカガクの講座は、Udemyでも高い評価を得ており、1つのコースで35,000人以上が受講している講座もあります。

実際、受講した方の生の声を見てみても、非常にポジティブなものばかりでした。(受講された方のレビューはこちらから)

※また、キカガクは一度スクールに申し込むと、全ての講座を無期限で受講することができるのでかなりお得です。

実際の講座を受講前に体験することができる

キカガクでは、無料体験を申し込むだけでUdemy上で高い評価を得たコースを実際に体験することができます。

受講できるコースは以下の2つで、合計20時間分の学習動画無料になります。

- Python&機械学習入門

- 脱ブラックボックスコース

整理すると、キカガクは以下の方におすすめです。

- まずは、スクールに行く前にAIや機械学習についてもっと詳しく知りたい

- 将来的に仕事でデータサイエンスなどに関われるようになりたい

- お得に資格取得をして、社内で更に活躍したい

※キカガクの講座の無料体験は、3分ほどですぐに学習を始めることができます。

Aidemy:大手企業での導入実績も多数!高品質なPython特化スクール【給付金あり】

Aidemy(公式):https://premium.aidemy.net/

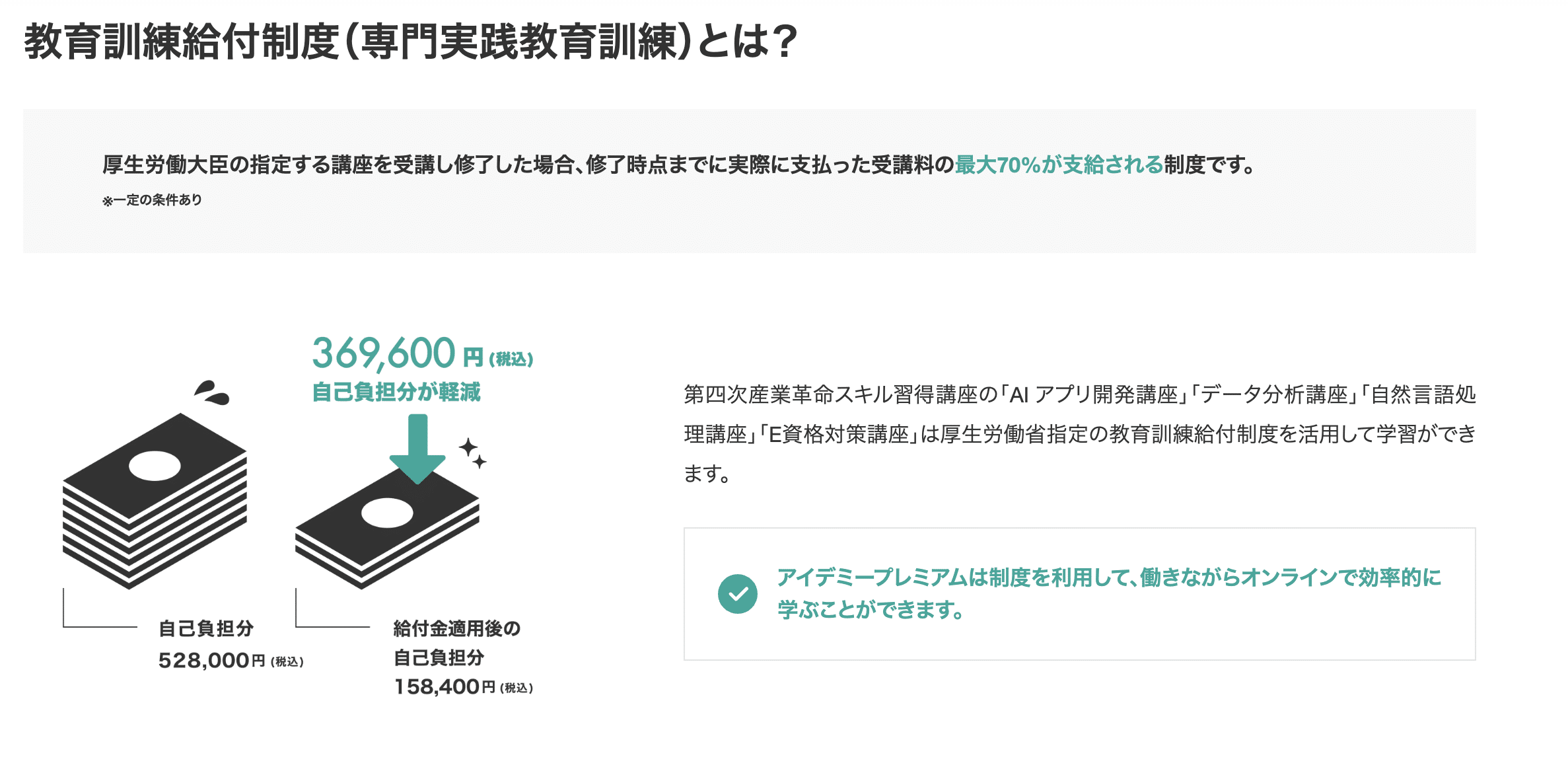

Aidemyは、AIに特化した東大発のプログラミングスクールです。 東証一部上場企業のAI研修などもおこなっている、日本最大級のAI教育サービスを提供しています。 AIを本格的に学べるプログラミングスクールの中でも、非常にハイレベルで高品質のスクールです。 Aidemyでは、Pythonに特化した講座を8種類用意しています。 各コースの金額は以下の通りです。 引用:https://premium.aidemy.net/(2023年4月時点。金額はすべて税込価格です) また、雇用保険の支給要件を満たしている方であれば、以下4つの講座で教育訓練給付制度(専門実践教育訓練)を利用できます。 対象者であれば、実際に支払った受講料のうち最大70%を支給してもらえる制度です。 Aidemyでは挫折しにくいサポートに加え、一部の講座では残りの受講期間を有意義に使える学び放題システムを利用することもできます。 丁寧なサポートを受けつつ、AIに特化した講座を受けたい方が学びやすいスクールです。 国の給付金を利用すれば安く受講できるので、興味のある方は対象者かどうか一度確認してみましょう。

3ヶ月

6ヶ月

9ヶ月

AIアプリ開発講座

¥528,000

¥858,000

¥1,078,000

データ分析講座

¥528,000

¥858,000

¥1,078,000

自然言語処理講座

¥528,000

¥858,000

¥1,078,000

実践データサイエンス講座

¥528,000

¥858,000

¥1,078,000

E資格対策講座

¥327,800

–

–

機械学習マスター講座

¥528,000

¥858,000

¥1,078,000

ビジネスAI対策講座

¥330,000

–

–

組織を変えるDX講座

¥330,000

–

–

TechAcademy:価格を抑えて、教養としてAI・Pythonを学びたいなら!オリジナルアプリ開発までサポート

2023年4月時点, TechAcademy公式サイトより TechAcademyは完全オンラインのプログラミングスクールです。 専任のエンジニアがマンツーマンでメンターとしてサポートしてくれます。 TechAcademyでAIを学べるコースとしては があります。 AIコースは、Python x AIを専門に学びたい人におすすめです。 具体的には、 などを、Pythonのライブラリで実装していきます。 一方で、データサイエンスコースは、Python x 統計学を学びたい人におすすめです。 より本格的に などを行っていきます。 30秒ほどで無料体験に申し込むと、 という特典があるので、まずは公式サイトから無料体験を受講してみるのがおすすめです! ※更新情報 2022年2月2日時点、TechAcademyでは3つの特別割引プランがあります。

AIコースとデータサイエンスコースのポイント

AIコース

データサイエンスコース

学習内容

Python

機械学習

ディープラーニング

クラスタリングプログラミング

機械学習

数学・統計学

モデルの構築

価格/受講期間

174,900円 / 1カ月

229,900円 / 2カ月174,900円 / 1カ月

229,900円 / 2カ月

公式ページ

https://techacademy.jp/course/ai

https://techacademy.jp/course/datascience

無料体験はこちら

①『先割』受講料5%OFF:対象プランに先行申し込みで適応

②『トモ割』10,000円割引:同僚や友人が一緒に受講される場合に適応

(別々のコースになっても割引は適用されます)

③ 『複数コースセット割引』:複数コースをセットで申し込むと、別々に学ぶよりも最大138,000円もお得に。

CodeCamp:価格を抑えながらマンツーマンで教養としてPython・データ収集を学びたいなら!

CodeCamp公式サイトより:https://codecamp.jp CodeCamp(コードキャンプ)は、完全オンライン・マンツーマンレッスン型のプログラミングスクールです。 中でも「データの抽出や整理を学びたい」という人におすすめなのが「Pythonデータサイエンスコース」です。 Pythonが活躍するデータサイエンスの世界には、 の3つのフェーズがあります。 データサイエンスコースでは、その中でも「データ収集」フェーズに重きをおいた学習内容となっています。 PythonのWebスクレイピングテクニックを使ってWeb上から必要なデータを抽出し、Excelやcsvの形に整理するというような、実務で役立つスキルを会得できるでしょう。 このスキルを会得すれば、面倒な単純作業をPythonにやらせることができるようになります。 気になる人は、無料体験レッスンで内容を体験してみてください。 DAINOTE記事経由でCodeCampの無料オンラインカウンセリングを受けるだけ! ※1万円OFFクーポンなどの他キャンペーンとの併用不可データサイエンス領域の「データ収集」を重視したカリキュラム

他の割引キャンペーンよりもお得に受講するチャンスです!

(当クーポン以外の割引キャンペーンとの併用はできません)

カウンセリング完了後のアンケートにクーポンコード694076を入力してください。

※クーポン取得後は7日間の利用期限があります

※アンケートに回答後、割引適用の詳細をメールでお知らせします。実際にメールが届くまでに最大で24時間程度かかることがあります

※アンケート回答後24時間経過してもメールが届かない場合は、迷惑メールBOXを確認してください

| データサイエンスコース | |

| 料金 / 期間 | 受講料金 165,000円(税込) / 2ヶ月 + 入学金 33,000円(税込) |

| 学習内容 | Pythonを利用したデータ収集 |

| 公式 | https://www.lp.codecamp.jp/python |

CodeCamp(公式):https://codecamp.jp

よくある質問①:Pythonって何ができるの?

Pythonは、プログラマー以外の人でも書けるように設計されている、可読性の高い言語です。以下のことができます。

- Pythonでスクレイピングという技術で、自動でネット上のデータを取得することができる

- PythonでAPIという技術を利用すれば、普通だと取得できない他人のツイッターのデータを取得して分析することができる

- Pythonを使えば、データの加工をエクセルより簡単にすることができる

- Pythonを使えば、データ分析ができる

- PythonはAIで機械学習やディープラーニングができる

- Pythonを使えば、Webアプリを作ることができる

よくある質問②:Pythonを学ぶなら、書籍のほうがよい?インターネットで学ぶほうがよい?

先に大事なことですが、初心者であれば書籍よりもインターネットの教材で学ぶことをお勧めします。理由としては以下2点です。

- 技術の進歩が速いので、すぐに本に書いてあることが時代遅れになってしまう

- 技術書は基本的に高い割には、難解な言葉で書かれていることが多い

個人的にはインターネットで学んだほうがよいと思っているので、インターネットで学べる教材についてご紹介します。

よくある質問③:Pythonを学ぶなら、無料の教材でよい?

Pythonの記事はネット上に無料でたくさんまとまっています。また、最近だとProgate等、初心者でも相当わかりやすいサイトがたくさん存在するので、無料のサイトを使うのがよいと思います。とはいえ、例えば

- Webアプリを作りたい!

- データ分析をしっかり学びたい!

- Web APIを使って業務効率化をしたい!

みたいな場合だと、内容も濃くなってくるので、情報量が多い有料の書籍、またはチュートリアルで学ぶのがよいと思います!

最後に

Pythonの基礎を学びその上で応用を学ぶ道筋を解説しました。

実際に作りながら学ぶのが一番効率的なので、是非基礎を学んだらすぐに応用に、勇気を出してチャレンジしてみましょう。

もしいなければ以下のスクールを利用してみるのがおすすめです。

どのスクールも無料体験・カウンセリングをやっているので、学習すべきことを相談したい・興味のある方は利用してみるがおすすめです。

あのマイクロソフトが導入するほどの高品質なPythonスクール。AI・機械学習・Python特化型。給付金で最大70%OFF。

【第2位】Aidemy(公式:https://aidemy.net/)

日本の大企業のDXで利用されている、高品質なPythonスクール。こちらもPython・AI・機械学習特化型

【第3位】TechAcademy(公式:https://techacademy.jp/)

価格を抑えて、教養としてAI・Pythonを学びたいなら!オリジナルアプリ開発までサポート。知名度抜群の総合型プログラミングスクール。

【第4位】CodeCamp(公式:https://codecamp.jp/)

価格を抑えながらマンツーマンで教養としてPython・データ収集を学びたいなら!同じく知名度抜群の総合型プログラミングスクール。

_TechAcademy_テックアカデミー_-2.png)