Pythonで毎日圧倒的に効率化している業務自動化術5選 【非エンジニアでもできます】

あのマイクロソフトが導入するほどの高品質なPythonスクール。AI・機械学習・Python特化型。給付金で最大70%OFF。

【第2位】Aidemy(公式:https://aidemy.net/)

日本の大企業のDXで利用されている、高品質なPythonスクール。こちらもPython・AI・機械学習特化型

【第3位】TechAcademy(公式:https://techacademy.jp/)

価格を抑えて、教養としてAI・Pythonを学びたいなら!オリジナルアプリ開発までサポート。知名度抜群の総合型プログラミングスクール。

【第4位】CodeCamp(公式:https://codecamp.jp/)

価格を抑えながらマンツーマンで教養としてPython・データ収集を学びたいなら!同じく知名度抜群の総合型プログラミングスクール。

「Pythonって具体的にどんなことが自動化できるの?Pythonの自動化の学習法ってどんなものがあるの?」

Pythonは本当に便利なので、ノンプログラマーでも書けると仕事が効率化できます。

Python本当に便利だ。

・毎日の自分の記事の検索順位を自動取得してSlackに通知

・Web上のデータを抜き出して、営業顧客リストを毎日自動作成

・ツイッターでインフルエンサーのRTが多いツイートを自動取得してCSVにダウンロードしてデータ分析マーケターが使えると超いいね。

— DAI (@never_be_a_pm) July 21, 2018

実際、この記事を読んでいるあなたは、「膨大なデータを手動でスプレッドシートに打ち込む・・・」「決まった時間にメールを送る等の定型業務」そんなめんどくさいこと自動化したい!と思ってますよね?

Pythonの学習に関しては、それぞれどんなことをしたいかで話が変わってくるのですが、基本的には、Pythonの基礎を固めて、チュートリアルでクローンアプリ作りつつプロからフィードバックをもらうことが効率的に学習を進めるコツです。

目次 (PRも含まれます) ほとんどの方は、この記事を読んでいるときにプログラミング経験がないと思うので、 とおもわれているかたも多いのではないでしょうか。 でも安心してください。Pythonの設計思想では、プログラマーではない人でもコードが書けるように、ほかのプログラミング言語よりも圧倒的にシンプルに書かれています。 なので、もしこの記事を読んでよさそうであれば、ぜひ学習を進めてみてくださいね。 ではでは、さっそく僕がPythonで業務自動化しているものの例をご紹介します。 僕自身がライターなので、 ってよく考えるですよね。例えば「Python」について書くとしたら、どんな記事がバズるんだろうっていうときに、Pythonを使って過去にバズった記事のURL、タイトルを15年分抽出して、それをデータ分析するようなことも可能です。しかも、こんな数行のコードで。 こんな感じでデータが自動収集されるスクリプトが起動されて その結果をCSVにダウンロードして これらのデータを、Pythonで分析できるJupyter Notebookを使って、毎年どんなキーワードが入っているタイトルがバズりやすいのか調べればいいわけです。こんな感じで、2017年度の日付を、ブックマーク数ごとに並び替えてあげれば。。。 こんな感じで、過去数万件のタイトルから、2017年のタイトルだけ取得できます。 ということがわかり、このキーワードを使って みごとに186 Contirubutionsを獲得したり。 このように、面倒5時間かかるリサーチも、たった5分でデータ収集できてしまうのが、Pythonの大きなメリットです。 例えば、海外のECサイトから毎日在庫情報を確認して、輸入して販売しているみたいな場合にも、Pythonは使えます。毎日在庫情報を確認するBotを作って、在庫がなければメール通知して足りないものを通知するようなBotを作成することができます。 ほかにも例えば、チケットを譲ってくれる人を見つけられるサイトがあるそうで、自分の見たいタイトルの舞台の名前を入れると、そのチケットを渡してくれる人を探すことができるそうなのですが、毎日検索して確認するのが面倒だそうなので、これを毎日プログラムが取得して、まとめたデータをSlackに通知してくれるようなプログラムを書いたりすることができます。 ほかにも、例えばSEO対策をしているコンテンツマーケターにもPythonは役に立ちます。例えば、キーワードの並び順によってキーワードボリュームが違ったり、競合性が変わったりしますよね。そういうキーワードを手入力で全部調べていくのは非常に手間です。 そういったときに、Pythonを利用してキーワードを自動で入れ替え、検索ボリュームを自動でAPIを利用して取得し、それをCSVにエクスポートすることも、ワンクリックで可能になります。 個人のアフィリエイターでもPythonで自動化ができます。例えば、ある特定のキーワードでGoogle検索の結果、存在するアフィリエイトコードを自動で抜き出して、そのコードからどういう商品が売れるのかを予測したりすることができます。これを自分の力で一つ一つやっていたら相当時間がかかりますが、秒速で終わらせることができます。 https://twitter.com/never_be_a_pm/status/1044727428776488960 これは実際に僕がやったわけではありませんが、毎日会社で打刻するのが面倒くさくて、Pythonでパソコンを起動した瞬間に打刻を自動化するプログラムを組んでいる人がいました。 Pythonの自動化を独学で学習していくのであれば、以下のことに注意しましょう。 例えば、スクレイピングを学習して、Web上から自動でデータを収集したいのであれば、以下のような学習ステップになります。 TechAcademyなどのプログラミングスクールでは、無料メンタリングをやっているので、先に相談しておくと、学習がスムーズに進められるので利用しておきましょう。 また、基礎学習を終えて、チュートリアルへ移行すると、分からないことやエラーが増え、一気に難易度が上がります。実際、このフェーズで時間をかなり使いますし、一気に挫折率が高まります。 なるべくわからないことやエラーに割く時間を減らしてなるべく早く業務に生かすには、メンターをつけて学習することが大切です。 周りにPythonに明るいエンジニアの方がいるならメンターになってもらいましょう。 もし周りにおらず、プログラミングスクールを利用して、講師をあなたのメンター代わりにすると良いかもしれません。

キカガク公式: キカガクは、給付金をもらってお得に学習しながらAI人材を目指すことができる、完全オンラインのプログラミングスクールです。 引用:キカガク公式 キカガクの講座は、Udemyでも高い評価を得ており、1つのコースで35,000人以上が受講している講座もあります。 実際、受講した方の生の声を見てみても、非常にポジティブなものばかりでした。(受講された方のレビューはこちらから) ※また、キカガクは一度スクールに申し込むと、全ての講座を無期限で受講することができるのでかなりお得です。 キカガクでは、無料体験を申し込むだけでUdemy上で高い評価を得たコースを実際に体験することができます。 受講できるコースは以下の2つで、合計20時間分の学習動画無料になります。 整理すると、キカガクは以下の方におすすめです。 ※キカガクの講座の無料体験は、3分ほどですぐに学習を始めることができます。

Pythonって実は難しくない…?

僕がPythonで毎日圧倒的に効率化させている業務自動化の例

①Web上でバズった記事のデータを10万件自動ダウンロードしてデータ分析

from selenium import webdriver

from pandas import *

import time

#Access to page

browser = webdriver.PhantomJS() # DO NOT FORGET to set path

url = "http://b.hatena.ne.jp/search/text?safe=on&q=Python&users=50"

browser.get(url)

df = pandas.read_csv('trend.csv', index_col=0)

#Insert title,date,bookmarks into CSV file

page = 1 #This number shows the number of current page later

while True: #continue until getting the last page

if len(browser.find_elements_by_css_selector(".pager-next")) > 0:

print("######################page: {} ########################".format(page))

print("Starting to get posts...")

#get all posts in a page

posts = browser.find_elements_by_css_selector(".search-result")

for post in posts:

title = post.find_element_by_css_selector("h3").text

date = post.find_element_by_css_selector(".created").text

bookmarks = post.find_element_by_css_selector(".users span").text

se = pandas.Series([title, date, bookmarks],['title','date','bookmarks'])

df = df.append(se, ignore_index=True)

print(df)

#after getting all posts in a page, click pager next and then get next all posts again

btn = browser.find_element_by_css_selector("a.pager-next").get_attribute("href")

print("next url:{}".format(btn))

browser.get(btn)

page+=1

browser.implicitly_wait(10)

print("Moving to next page......")

time.sleep(10)

else: #if no pager exist, stop.

print("no pager exist anymore")

break

df.to_csv("trend1.csv")

print("DONE")

year2017 = df[df["date"].str.contains("2017/", na=False)]

year2017.sort_values(by=["bookmarks"], ascending=False)

実際にこんな感じでデータ分析した結果、

【Python】スクレイピング→データ収集→整形→分析までの流れを初心者向けにまとめておく ~Pythonに関するはてな記事を10年分スクレイピングし、Pythonトレンド分析を実際にやってみた~ というタイトルでQiitaに書いてみたところ②他社のECサイトの在庫データを毎日Botで自動確認し、足りない場合はリストでメールで通知

③SEO対策で必要なキーワードを自動でマイニング

④Googleの検索結果から、検索順位とそのページのアフィリエイトタグを埋め込み、アフィリエイターの競合分析

⑤会社の打刻忘れを防止するためにブラウザ自動操作で打刻

Pythonの自動化を独学で学習していくときに知っておきたい3ポイント

効率よく最短でPythonやAIを利用して業務自動化する方法を学ぶには?

業務の自動化や効率化ができるPythonを学びたい方向けおすすめスクール

あのマイクロソフトが導入するほどの高品質なPythonスクール。AI・機械学習・Python特化型。給付金で最大70%OFF。

日本の大企業のDXで利用されている、高品質なPythonスクール。こちらもPython・AI・機械学習特化型

価格を抑えて、教養としてAI・Pythonを学びたいなら!オリジナルアプリ開発までサポート。知名度抜群の総合型プログラミングスクール。

価格を抑えながらマンツーマンで教養としてPython・データ収集を学びたいなら!同じく知名度抜群の総合型プログラミングスクール。キカガク:最大70%割引き!給付金を使ってお得に学べる高品質Python特化型スクール

https://www.kikagaku.ai/

コースの特徴

オンライン動画学習サービス、Udemyでも絶賛された高品質の学習コンテンツ

実際の講座を受講前に体験することができる

Aidemy:大手企業での導入実績も多数!高品質なPython特化スクール【給付金あり】

Aidemy(公式):https://premium.aidemy.net/

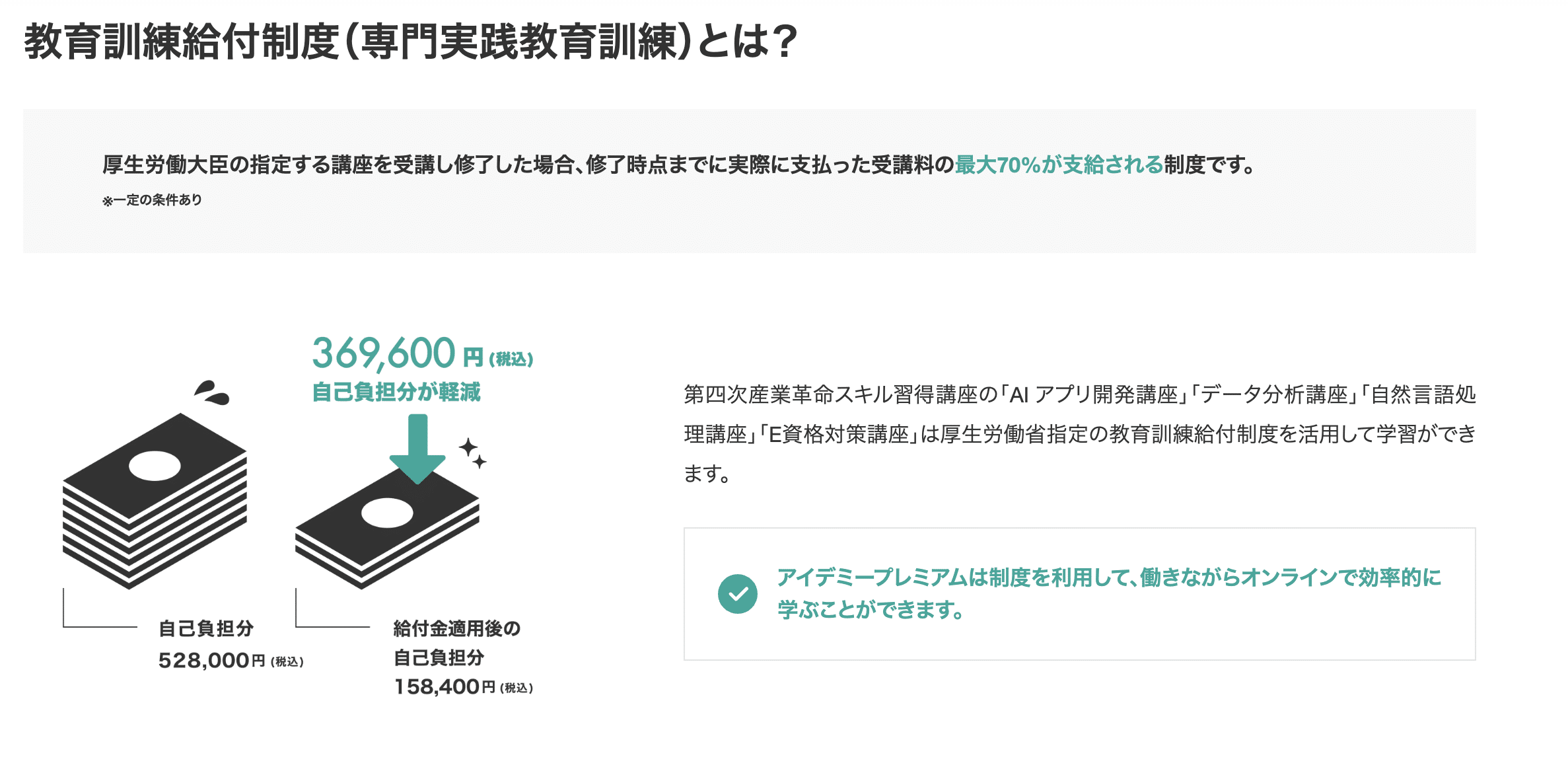

Aidemyは、AIに特化した東大発のプログラミングスクールです。 東証一部上場企業のAI研修などもおこなっている、日本最大級のAI教育サービスを提供しています。 AIを本格的に学べるプログラミングスクールの中でも、非常にハイレベルで高品質のスクールです。 Aidemyでは、Pythonに特化した講座を8種類用意しています。 各コースの金額は以下の通りです。 引用:https://premium.aidemy.net/(2023年4月時点。金額はすべて税込価格です) また、雇用保険の支給要件を満たしている方であれば、以下4つの講座で教育訓練給付制度(専門実践教育訓練)を利用できます。 対象者であれば、実際に支払った受講料のうち最大70%を支給してもらえる制度です。 Aidemyでは挫折しにくいサポートに加え、一部の講座では残りの受講期間を有意義に使える学び放題システムを利用することもできます。 丁寧なサポートを受けつつ、AIに特化した講座を受けたい方が学びやすいスクールです。 国の給付金を利用すれば安く受講できるので、興味のある方は対象者かどうか一度確認してみましょう。

3ヶ月

6ヶ月

9ヶ月

AIアプリ開発講座

¥528,000

¥858,000

¥1,078,000

データ分析講座

¥528,000

¥858,000

¥1,078,000

自然言語処理講座

¥528,000

¥858,000

¥1,078,000

実践データサイエンス講座

¥528,000

¥858,000

¥1,078,000

E資格対策講座

¥327,800

–

–

機械学習マスター講座

¥528,000

¥858,000

¥1,078,000

ビジネスAI対策講座

¥330,000

–

–

組織を変えるDX講座

¥330,000

–

–

TechAcademy:低価格でPythonを学びたいなら!オリジナルアプリ開発までサポート

2023年4月時点, TechAcademy公式サイトより TechAcademyは完全オンラインのプログラミングスクールです。 専任のエンジニアがマンツーマンでメンターとしてサポートしてくれます。 TechAcademyでAIを学べるコースとしては があります。 AIコースは、Python x AIを専門に学びたい人におすすめです。 具体的には、 などを、Pythonのライブラリで実装していきます。 一方で、データサイエンスコースは、Python x 統計学を学びたい人におすすめです。 より本格的に などを行っていきます。 30秒ほどで無料体験に申し込むと、 という特典があるので、まずは公式サイトから無料体験を受講してみるのがおすすめです! ※更新情報 2022年2月2日時点、TechAcademyでは3つの特別割引プランがあります。

AIコースとデータサイエンスコースのポイント

AIコース

データサイエンスコース

学習内容

Python

機械学習

ディープラーニング

クラスタリングプログラミング

機械学習

数学・統計学

モデルの構築

価格/受講期間

174,900円 / 1カ月

229,900円 / 2カ月174,900円 / 1カ月

229,900円 / 2カ月

公式ページ

https://techacademy.jp/course/ai

https://techacademy.jp/course/datascience

無料体験はこちら

①『先割』受講料5%OFF:対象プランに先行申し込みで適応

②『トモ割』10,000円割引:同僚や友人が一緒に受講される場合に適応

(別々のコースになっても割引は適用されます)

③ 『複数コースセット割引』:複数コースをセットで申し込むと、別々に学ぶよりも最大138,000円もお得に。

CodeCamp:価格を抑えながらマンツーマンでPython・データ収集を学びたいなら!

CodeCamp公式サイトより:https://codecamp.jp CodeCamp(コードキャンプ)は、完全オンライン・マンツーマンレッスン型のプログラミングスクールです。 中でも「データの抽出や整理を学びたい」という人におすすめなのが「Pythonデータサイエンスコース」です。 Pythonが活躍するデータサイエンスの世界には、 の3つのフェーズがあります。 データサイエンスコースでは、その中でも「データ収集」フェーズに重きをおいた学習内容となっています。 PythonのWebスクレイピングテクニックを使ってWeb上から必要なデータを抽出し、Excelやcsvの形に整理するというような、実務で役立つスキルを会得できるでしょう。 このスキルを会得すれば、面倒な単純作業をPythonにやらせることができるようになります。 気になる人は、無料体験レッスンで内容を体験してみてください。 DAINOTE記事経由でCodeCampの無料オンラインカウンセリングを受けるだけ! ※1万円OFFクーポンなどの他キャンペーンとの併用不可データサイエンス領域の「データ収集」を重視したカリキュラム

他の割引キャンペーンよりもお得に受講するチャンスです!

(当クーポン以外の割引キャンペーンとの併用はできません)

カウンセリング完了後のアンケートにクーポンコード694076を入力してください。

※クーポン取得後は7日間の利用期限があります

※アンケートに回答後、割引適用の詳細をメールでお知らせします。実際にメールが届くまでに最大で24時間程度かかることがあります

※アンケート回答後24時間経過してもメールが届かない場合は、迷惑メールBOXを確認してください

| データサイエンスコース | |

| 料金 / 期間 | 受講料金 165,000円(税込) / 2ヶ月 + 入学金 33,000円(税込) |

| 学習内容 | Pythonを利用したデータ収集 |

| 公式 | https://www.lp.codecamp.jp/python |

CodeCamp(公式):https://codecamp.jp

Pythonを無料で学べるサービス

- Pythonで簡単なアプリを開発してみたい

- でもまずは無料で勉強してみたい

- ただの基礎ではなく、応用が聴くような技術を身に付けたい

という方向けにおすすめのサービスをご紹介します。

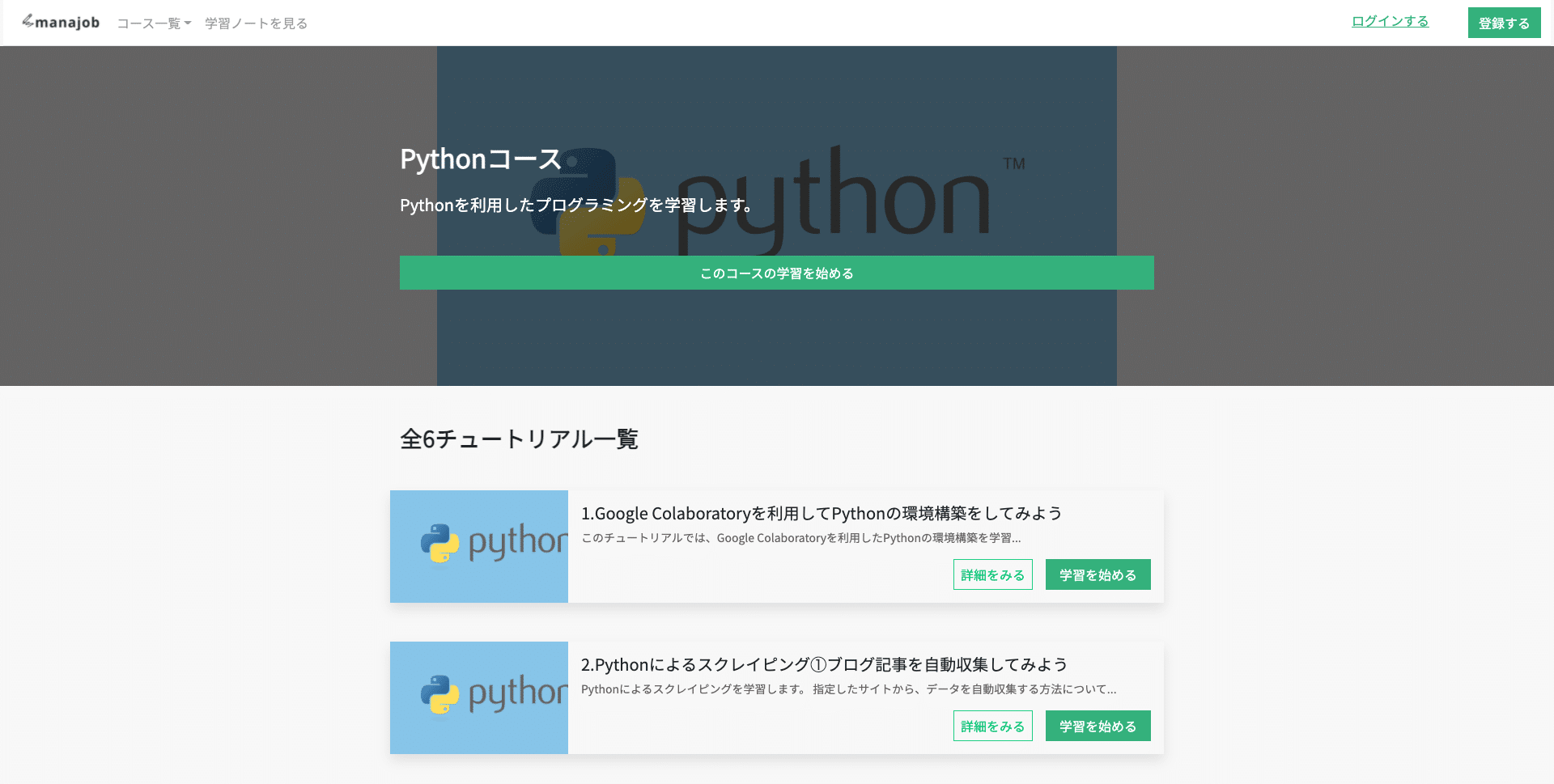

Manajob

Manajobは、株式会社インディバースが運営する動画+テキストでIT系全般を学習できる越境型IT学習サービス。

- Pythonを利用した自動化

- Web制作

など、幅広いジャンルのコンテンツを、無料で学習することができます。

実際に

- ブログサイトのデータ収集

- 自動ログインによる定期実行

- データ分析

- エステサロンのホームページ作成

など、ゴールから逆算して学習することができるのでおすすめです。

Manajobに無料登録して学習をはじめるまた、僕のYoutubeのチャンネルの以下の動画を見ればPythonで自動化できることが分かりやすく解説されているので、こちらもご覧ください。

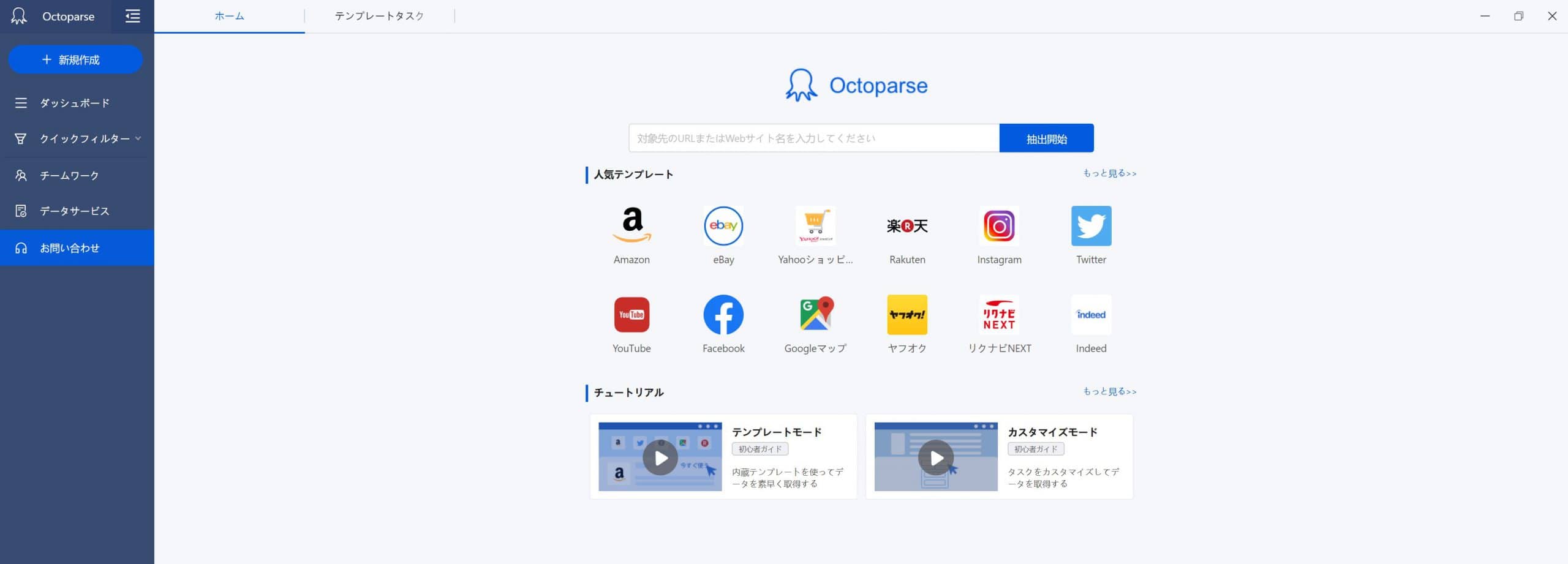

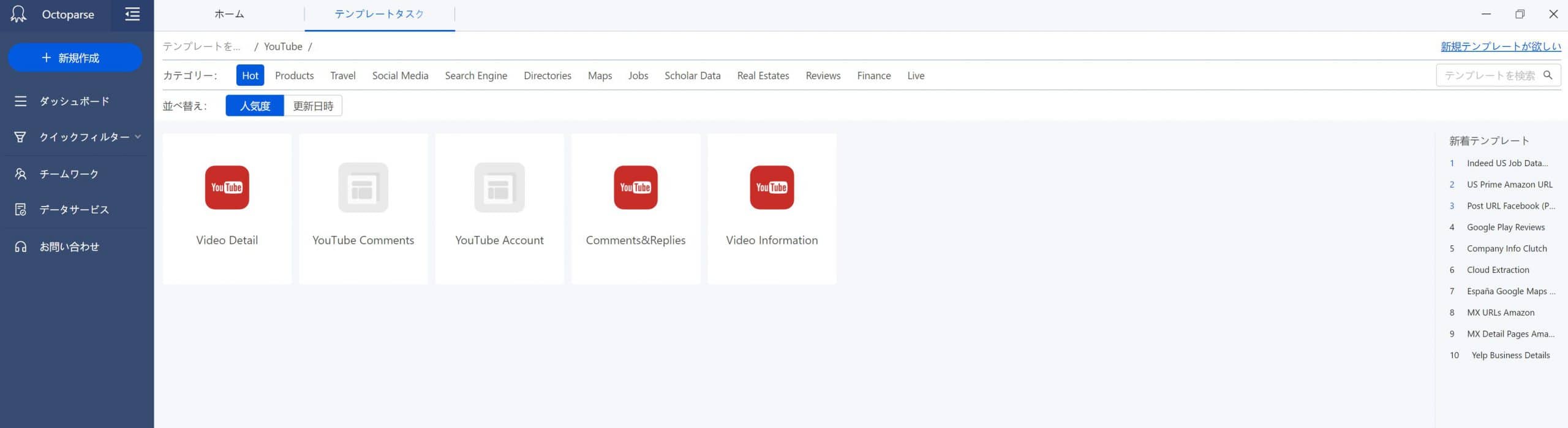

プログラミングを書かずにスクレイピングをするなら Octoparse

公式サイト:https://www.octoparse.jp/

『Octoparse』は、無料かつプログラミング不要のWebスクレイピングツールです!

「Octoparse」のいいところは、数えたらきりがないのですが、絞ると以下の3点です!

- 無料版できることがかなり多い。

- プログラミング経験が全くない人でも、データの取得を自動化できる。

無料版できることがかなり多い。

Octoparseは、無料版でも以下のようなデータを簡単に取得することができます。

- ECサイトの検索結果や、商品詳細などのデータ

- メディアやニュースサイトなどの記事データ

- SNSの投稿データ

有料版と無料版の違いは、いくつかありますが代表的なものは以下の2つです。

- タスクの定期実行ができない。

- APIを使うことができない。

プログラミング経験が全くない人でも、データの取得を自動化できる。

また、Octoparseを利用する一番のメリットは、プログラミング経験が全くない人でもスクレイピングをして、データ取得を自動化できるということです。

通常、プログラミング完全未経験の方がスクレイピングをしようとすると、以下のような課題に直面します。

- HTML、CSS、JavaScript、Pythonなど、複数の言語を学習しなければならない。

- PC上で環境構築などをしなければならない。

- 定期実行をしたい場合は、仮想サーバーなどの知識もつける必要がある。

そもそも、自分でやってみたもののエラーがでてほしいデータが取得できないなどの事態に陥る場合もあり、結局時間をかなり浪費してしまう…ということもあり得ます。

※有料版を使えば、データ取得の定期実行なども可能なため、プログラミングを学習しなければできなかったことの多くをOctoparseを使えばクリックだけで置き換えることが可能になります。

_TechAcademy_テックアカデミー_-2.png)